一、ELLA是什么东西?

ELLA是腾讯研究人员开发的一种高效大型语言模型适配器。其目的在于增强文本到图像生成模型在处理复杂文本提示时的语义对齐能力。ELLA通过融合大型语言模型(LLM),显著提升了模型的文本对齐性能,而且无需对U-Net或LLM进行额外的训练。

二、ELLA的网站链接是:

1、Github上的开源地址:

这是腾讯QQGY实验室ELLA的GitHub链接。

项目地址:

请访问以下网址查看更多信息:https://ella-diffusion.github.io/

论文地址:

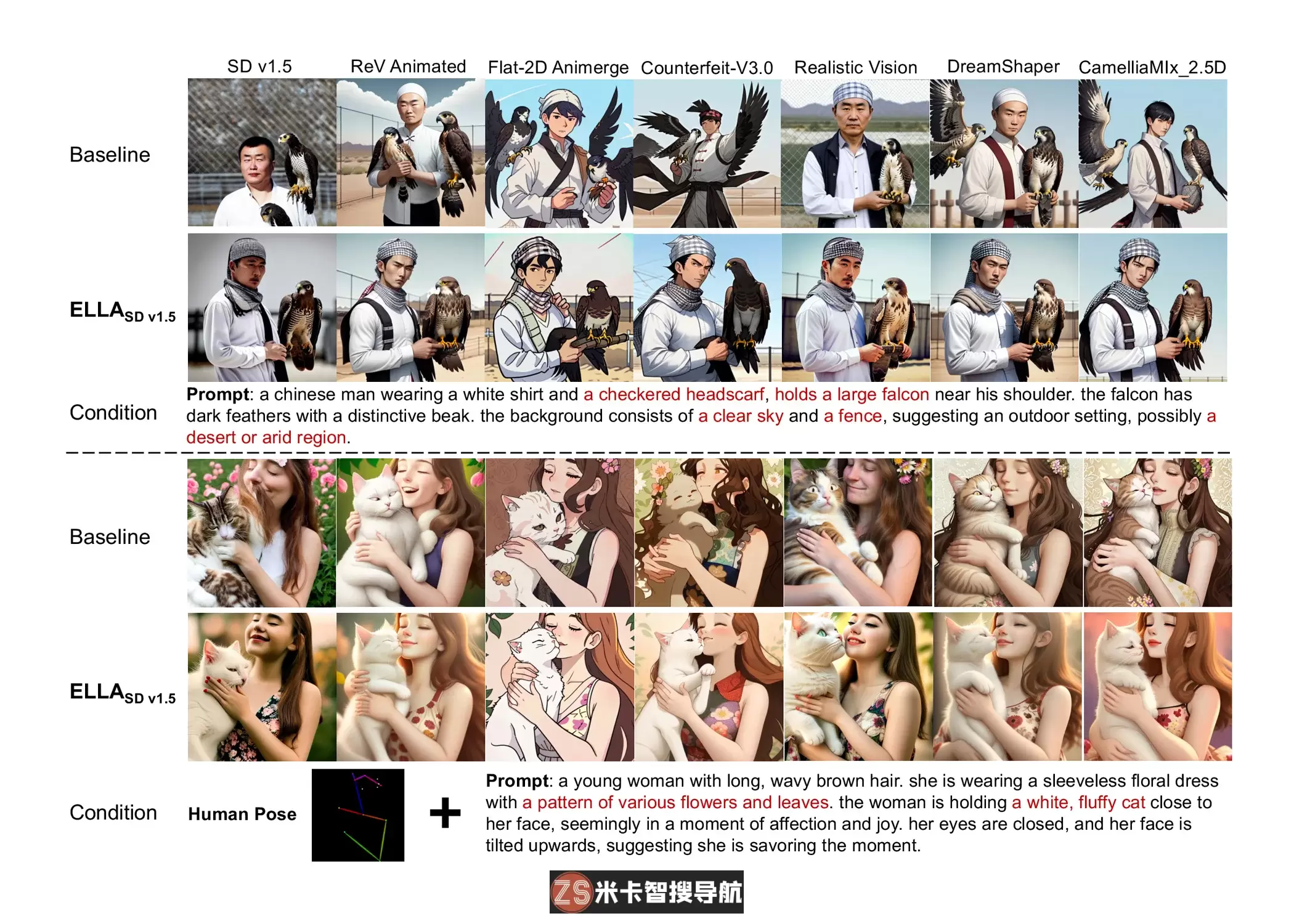

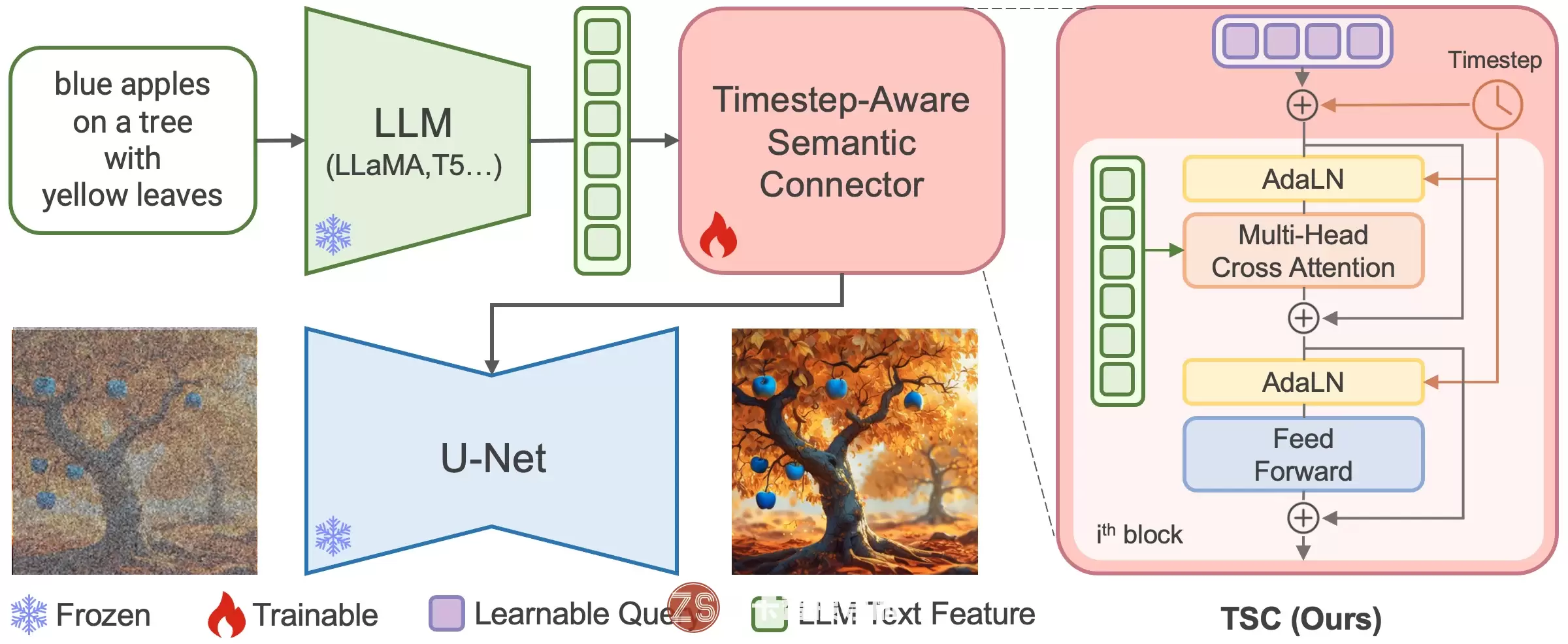

三、ELLA的特性概述:语义对齐增强:通过与大型语言模型(LLM)相结合,ELLA提升了对文本提示中多样对象、细节属性和复杂关系的理解,生成更匹配文本提示的图像。时序感知语义提取:ELLA的TSC模块可根据不同时间步骤提取语义信息,使生成模型能够在不同阶段专注于文本内容。无需重新训练:ELLA的独特设计使得它能直接应用于现有的预训练LLM和U-Net模型,省去了重新训练的需求,节省了大量计算资源和时间。高度兼容性:ELLA可以轻松整合到现有社区模型(如Stable Diffusion)和下游工具(如ControlNet)中,提升它们处理复杂文本提示的效能。灵活的token长度:在ELLA的训练中使用了长合成字幕,最大token数设定为128。在使用短字幕进行ELLA测试时,除了前面提到的采样技术外,还可以使用”flexible_token_length”技巧。

将标记生成器的max_length参数设置为None,以便消除文本标记的填充或截断。我们注意到这一方法可以提升生成图像质量,尤其是对应短标题的情况。ELLA模型的概述如下:

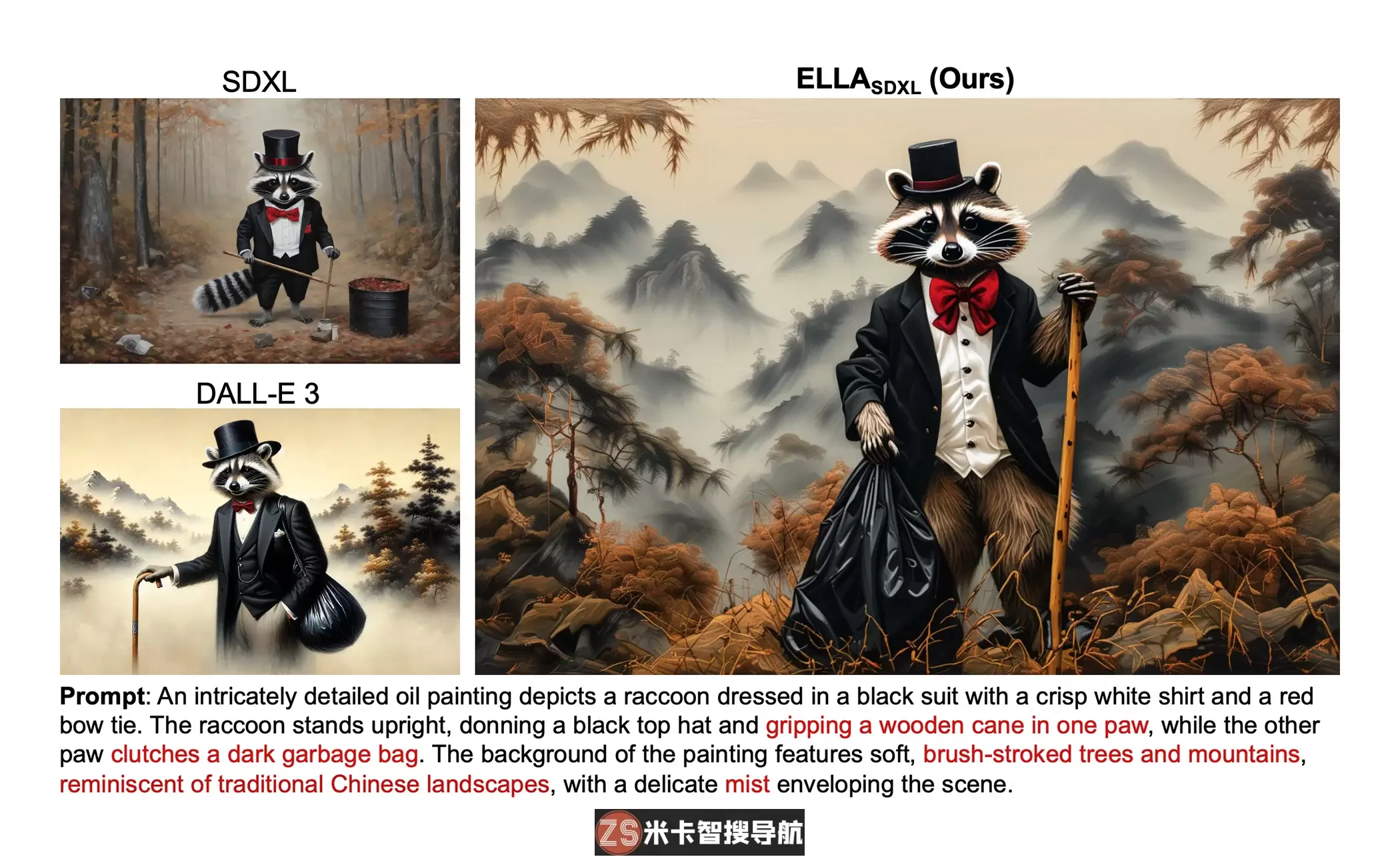

扩散模型在文本生成图像领域显示出很好的表现。但是,大部分这类模型目前仍在使用 CLIP 作为文本编码器,这导致它们受限于理解密集提示的能力,这些提示包括多个对象、详细属性、复杂关系、长文本对齐等等。本文中,我们介绍了一个名为ELLA的高效大型语言模型适配器,为文本生成图像的扩散模型提供了强大的大型语言模型(LLM),从而增强文本对齐,这是为那些没有受过 U-Net 或 LLM 培训的模型准备的。为了实现两个预训练模型的无缝连接,我们研究了一系列语义对齐连接器设计,并提出了一个新颖的组件,即时间步感知语义连接器(TSC),它可以从LLM中动态提取与时间步相关的条件。我们的方法能够适应去噪过程中不同阶段的语义特征,协助扩散模型解释采样时间步长的冗长而复杂的提示。另外,ELLA 可以轻松地结合社区的模型和工具,提升其提示跟踪能力。为了评估文本生成图像模型中的密集提示跟踪性能,我们引入了密集提示图基准(DPG-Bench),其中包含具有挑战性的1K个密集提示。通过大量实验验证表明,相对于最先进的方法,ELLA 在密集提示跟踪方面表现出卓越性,特别是在涉及不同属性和关系的多个对象组合时。

我们提出了一种创新的轻量级方法 ELLA,为现有的基于 CLIP 的扩散模型增添了强大的LLM能力。ELLA无需经过U-Net和LLM的培训,就能增强提示跟随能力,并实现对文本到图像模型的深入密集理解。

我们开发了一个时间感知语义连接工具,它可以从经过预训练的LLM中提取与时间步相关的条件,并应用在不同去噪阶段。我们的TSC可以动态调整语义特征的采样时间步长,从而有效地调整冻结的U-Net在不同的语义层面上。

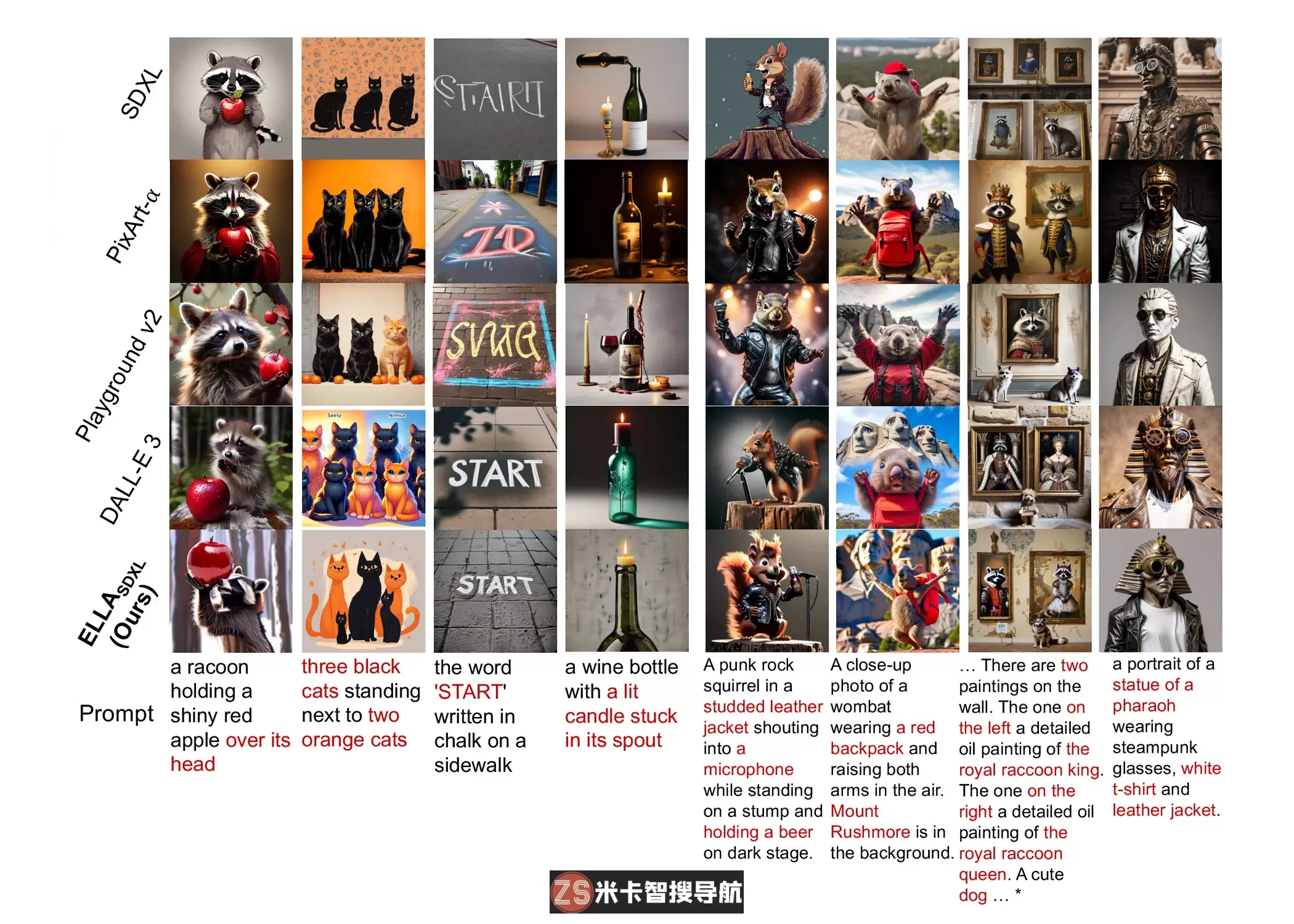

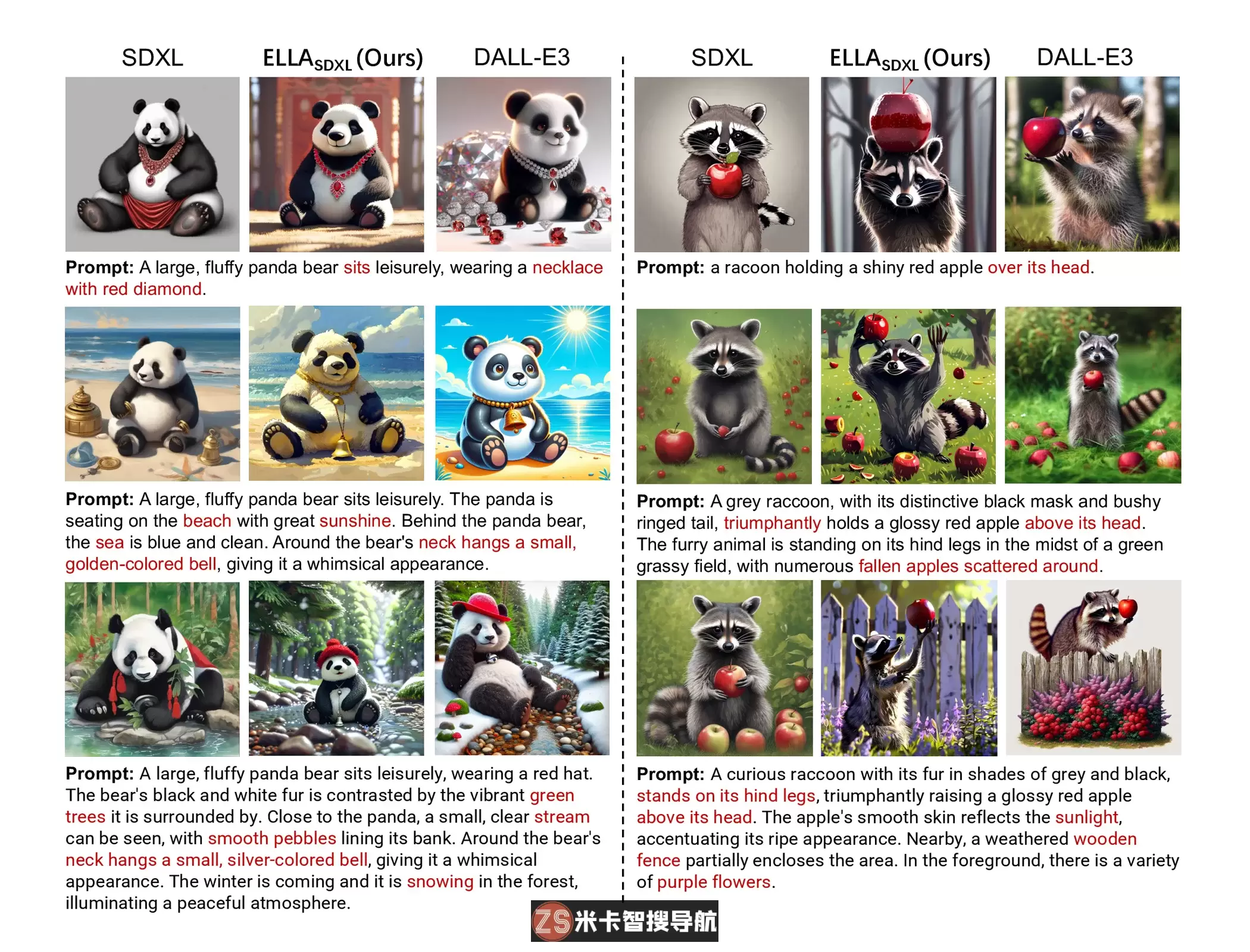

ELLA、SDXL、PixArt-alpha、Playground v2 和 DALL-E 3 之间的比较。左侧四栏只包含1或2个实体,但右侧四栏包含对应有2个以上实体的密集提示。所有提示均来自PartiPrompts。ELLA与主流人工智能模型的比较:

ELLA经过培训后,能够平滑地整合社区模型以及 LoRA 和 ControlNet 等后续工具,以提升文本图像对齐的效果。